AI for Science

AI4S概述

AI for science(AI4S, 人工智能在科学中的应用)是指利用人工智能技术解决科学研究中复杂问题和挑战的新兴领域。随着计算能力的快速增长和机器学习算法的进步,AI在各个科学领域的应用日益广泛,从基础研究到应用开发都在推动科学的前沿。

以下为AI4S的简要发展历程:

- 2006年:Geoffrey Hinton等研究人员发表了关于深度神经网络的论文,标志着深度学习在机器学习中的复兴。这一技术重新引起了对多层神经网络的兴趣,并为未来的进展奠定了基础。

- 2015年:谷歌DeepMind开发的AlphaGo击败人类围棋冠军,这一成就不仅是在策略游戏中AI能力的巅峰展示,也突显了AI在复杂决策和模式识别方面的潜力;

- 2018年:DeepMind的AlphaFold通过深度学习预测蛋白质的结构,解决了长期以来生物医药领域中的重大挑战,这一成就加速了药物设计和生物研究的进程。

- 2020年,鄂维南和学生组成的深度势能团队,利用机器学习与物理建模相结合的方法(DeePMD)成功模拟了包含 1 亿个原子的量子分子动力学系统,并获得了当年的国际高性能计算应用领域的最高奖戈登贝尔奖;

- 2022年:ChatGPT 横空出世;

- 2023年:科技部启动"人工智能驱动的科学研究"专项部署工作。

AI for Science的发展正日益成为AI界和科学界共同关注的热点。从AI求解薛定谔方程、控制论方程到加速分子模拟、预测蛋白结构、赋能药物和材料设计等多个领域,在不到几年的时间内,AI4S的发展已超出预期。下图为Nature在2023年对科学界AI使用情况的调查结果,显示了AI在科研论文中的总体渗透率达到了8%,并且在更多的传统学科领域里依然呈现出不断上升的趋势。

在国内,2023年科技部与自然科学基金委联合启动了“人工智能驱动的科学研究”专项,布局前沿科技研发体系,将AI4S作为重要发展方向并纳入科技创新2030计划的新一代人工智能重大项目之一。指南中重点部署了“重大科学问题研究的AI范式”,涵盖地球科学、空间科学、化学和材料科学、生物医药科学等领域的创新研究。国际上,Elon Musk宣布推出x.ai项目,旨在建立理解自然规律的人工智能系统;前谷歌CEO Eric Schmidt捐资1.48亿美元设立AI for Science博后奖学金,已经涵盖9所大学;微软成立专门的AI4science部门;英伟达与IIT合作发布AI for Science公开课程;龙头药企赛诺菲全面投入AI for (life) science;美国能源部联合5大国家实验室发布AI for Science, Energy & Security先进科研课题指引;OECD向全球政策制定者发布AI在科学领域的综述与政策建议,等等. 从学界到产业、从生命科学到材料科学,众多优秀的AI for Science应用正加速涌现,AI for Science已在全球呈现燎原之势。

AI4S的核心问题

总体而言,AI for Science可以分为两大类,一类是AI大模型辅助的科学研究,包括但不限于文献的分析和解读,科学数据分析和模式识别,科学实验设计和优化,文档写作的辅助等等。另一类则是AI计算与高性能科学计算的深度结合,力图通过在AI中引入物理定律以及在科学计算中引入AI的辅助来同时推进两者的发展。本文将主要讨论第二类AI4S。

作为长期困扰科学计算和应用数学领域的一个障碍,如何解决高维度问题是近年来传统高性能计算领域面临的主要挑战之一。以分子动力学模拟为例, 随着体系原子数N的增加, 其原子间的相互作用势能的自由度将不少于3N(即空间坐标数), 在这种情况下, 传统的平滑性正则化方法通常表现不佳,无法有效处理函数复杂性。即使依靠“堆算力”的方式试图强行解决,其精确度和成本收益比也经常会变得不可接受。相比之下,神经网络结构在处理高维问题时的表现已经在传统AI领域(如图像识别,自动驾驶等)得到很好的证明。而也有不少研究显示, 机器学习模型本身在高维函数逼近方面表现也相当出色,与蒙特卡洛方法(Monte Carlo)类似, 其计算精度并没有随着系统维度增加而变得难以接受, 这使得以前难以解决的高维控制论和偏微分方程问题�成为可能。

反过来讲, 虽然近年来AI的长足发展使大家叹为观止,尤其是近年来大语言模型和生成式AI的能力远远超出了预期。但是由于单纯基于数据加神经网络的AI方法论本身是一个“黑箱”,无法单纯地从数据中有效和准确地理解客观世界的物理定律,这就造成了模型给出的内容让人感觉似是而非,不敢放心使用。一个显著的例子就是OpenAI的图像生成模型Sora产生的一段视频中,椅子的“反重力”行为。

综合这两点, 一面传统科学可以借助AI的力量来克服现代科学问题中的”维数灾难”,使得某些原来不可能完成的计算任务成为可能,另一面,AI模型可以借助客观世界的精确物理学规律对其训练过程的“注入”,使其生成的结果更真实,让人们更想使用,用起来更加放心, 这就是AI for Science的基本出发点。

如上所述,既然AI for Science的挑战之一就是如何保证模型预测结果符合物理规律并具有可解释性,那么这就需要在训练过程中有效地融入客观物理规律。为了理解AI for Science发展的大趋势,可以根据这种“融入”的强度将其分为不同等级,如下所示:

-

Level 0 无约束:这一层次的方法主要通过提高数据的质量来增强模型的物理准确性,但不能保证模型在推断时严格遵循物理定律。例如,现在的大部分端到端训练的生成式AI模型,直接利用大语言模型执行的科学推理任务,还有例如AlphaFold这类纯粹数据驱动的分子结构预测模型等。

-

Level 1 弱约束:在这一层次中,模型通过间接加强物理定律来提高准确性。例如,下文将要介绍的物理信息约束神经网络(PINN)将微分方程作为损失函数的一部分,通过损失函数的优化来引导参数优化,确保模型对包含物理定律的系统进行准确逼近。这种方法结合了数据拟合和物理约束的双重优化。

-

Level 2 强约束:最高层次的方法直接在模型架构中建立物理基本定律,以最大程度地保证模型行为符合物理学原理。例如,构建哈密顿或拉格朗日神经网络,这些网络结构严格尊重特定的物理守恒定律,如能量守恒。这种方法虽然保证了模型的物理合理性,但也限制了模型的灵活性和表达能力。

可以简单地讲,近年来AI4S发展的大趋势就是从L0的AI逐步过渡到L2的AI,即AI模型中的物理学约束越来越强,AI生成的结果也越来越真实。在这个过程中,AI计算和高性能科学计算的边界将逐渐模糊,呈现出一种“你中有我,我中有你”的态势,同时对这两种算力的需求都将大大增长。

AI4S与算力基础设施

计算硬件的持续进步与科学计算的推动密不可分,共同促进了算法处理能力的飞跃。高性能计算(HPC)作为基石,集合大量计算资源,创造出超越常规计算机极限的强大环境,以应对巨量数据和复杂计算挑战。AI4S强调高效算法设计与强大计算能力的结合,分布式计算通过合理任务分配,充分利用HPC资源,扩展计算规模。云计算提供灵活高效的解决方案,解决传统HPC高成本与更新缓慢问题。与此同时,异构计算技术的崛起(GPU、FPGA、SoC等)也给AI4S注入了新得活力,与��其在传统AI和HPC领域扮演的重要角色相类似,异构计算也将成为AI4S时代算力的支柱。

在此需要强调的是,全功能通用GPU在AI4S时代有其独特的优势。 全功能GPU是指既有AI训练和推理能力, 又有大规模科学计算能力的GPU; 前者强调对神经网络相关计算的优化,而后者则强调高精度浮点数计算能力. 在AI for science时代,全功能GPU算力相比纯粹AI推理算力具有几个显著的优势:

-

多用途性: 全功能GPU不仅仅用于AI推理,还可以支持科学计算中的各种算法和模型。与全功能GPU配套的软件栈可在单一环境里同时支持AI和科学计算。例如,它们可以用于解决数值模拟、分子动力学模拟、流体力学模型等各种科学问题,这些问题通常需要大量的计算资源和复杂的浮点运算, 而这些计算的结果又可以作为AI模型训练的数据加以利用。

-

灵活性和效率: 通用GPU通常具有良好的可编程性, 其完整的开发者生态可以大大降低开发门槛, 使得科学计算领域和AI领域的开发者都能轻松使用; 而且因为它们在处理复杂科学计算和大规模AI训练数据时都具有相对优异的性能, 且能够针对不同的应用进行优化,所以通用GPU平台可以提供更高的AI+Science综合计算能力。

-

单一硬件平台: 使用全功能GPU可以避免为AI推理和科学计算分别购买不同的硬件设备或者使用不同的计算资源。这种集成的方法可以简化管理和维护,减少硬件之间数据传输和兼容性问题。

-

功能全面: 全功能GPU能够支持多种类型的工作负载,包括深度学习推理、科学模拟、数据分析、数据可视化、效果渲染等。这意味着同一套硬件可以在不同的科研项目中灵活应用,而无需每次都调整或增加额外的�硬件设备。另外, 科学计算产生的结果和AI训练所需的数据也可以共享存储资源, 这进一步节约了硬件成本。

-

成本节约: 虽然全功能GPU的初期投资可能较高,但与购买专门用于AI推理或科学计算的专用设备相比,总体成本更低。维护一套全功能GPU系统通常比维护多个不同类型的硬件系统更为经济,尤其是在硬件更新和升级方面。

AI4S应用案例1: 物理神经网络求解PDE

AI for science在应用数学领域展示了许多令人振奋的进展和实际应用。其中,AI技术在微分方程求解方面通过数据驱动的建模显著提高了精确度和效率,尤其在处理复杂的非线性系统如流体动力学和天气预报中表现突出。在这些进展中,物理神经网络(Physics-informed Neural Network,简称PINN)是一个很有代表性的工作。

2019年,布朗大学应用数学系研究团队提出了PINN,并发表在《计算物理学期刊》(Journal of Computational Physics)。自从发表,PINN成为了AI for Science领域最常见的关键词之一。

简而言之,PINN的基本目的是将物理方程作为限制加入到神经网络之中,使得拟合得到的结果更加满足物理规律。这个限制如何实现呢?关键点就在于PINN神经网络在训练迭代的过程之中优化的不仅仅是网络自己的损失函数,还包括了物理方程每次迭代的差值,使得模型的预测结果在不符合某些既定的物理学方程时产生较大的loss。

换句话说,模型训练的目标是双重的:既�要减小预测值与实际观测数据间的差距,也要确保预测结果与物理定律保持一致。

举例来说, 对于热传导问题, 其物理学规律可以用如下的微分方程表示:

其中u(x,t)代表温度场分布随着空间和时间的变化,是要学习和预测的对象。另一方面,作为基本训练数据(ground truth),假设我们有温度场变化的实际观测数据集{uobs, (x, t)}

那么物理信息误差项可以定义为:(即把推理结果带入微分方程后产生的误差)

数据误差项可以定义为:(即推理结果与观测数据集的误差)

加权后AI训练的总损失函数可以写为:

这就使得AI网络在被训练时同时得到了“数据驱动”和“物理规律驱动”,其预测结果更能体现出物理规律方面的自洽性。

PINN方法创新性地将物理学先验知识,如偏微分方程,直接嵌入模型训练中,通过在损失函数中增加物理约束项,确保模型预测结果既符合数据又遵循物理规律。这不仅减少了对大量高质量观测数据的依赖,还在数据稀缺场景下展现出优越性,因为物理法则提供强有力的补充指导。在后面将要介绍的英伟达Modulus软件框架中,PINN就扮演者重要的角色。

AI4S应用案例2: 深度势能分子动力学模拟(2020戈登贝尔奖)

在传统高性能科学计算领域,分子动力学应用非常广泛,比如如果我们想要预测一种新型纳米材料的性质,就需要计算其海量原子间的相互作用。传统分子动力学在计算势函数的时候依赖经验力场,导致结果不准确;第一性原理的方法通过量子力学模型计算,虽然可靠但是效率低,在原子数大于100的系统中计算速度非常慢,难以大规模使用。

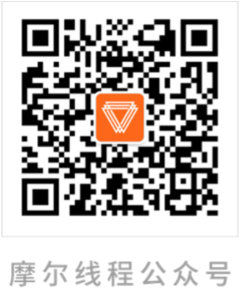

而基于机器学习的分子动力学方法,即依靠量子力学模型提供训练数据,用深度神经网络对高维势函数进行拟合,就可以同时保证算法的准确性和高效性。这种方法称为深度势能分子动力学 (deep potential molecular dynamics,DeePMD)。它是一个可靠的、具��有第一性原理精度的原子模拟工具。结合高性能计算,它将以第一性原理精度分子动力学模拟的能力从只能处理数千个原子的体系扩展到处理170亿个原子的体系,此项研究也因为其颠覆性的进展而获得了2020年的戈登贝尔奖。

Deep Potential方法的特性可以总结如下:

-

数据集构建:使用大规模分子动力学模拟+第一性原理计算产生的数据作为训练集,包括原子位置、速度、势能等信息。(此处需要大规模HPC算力)

-

神经网络架构:设计适合分子系统特征的神经网络结构,通常采用深度卷积神经网络(CNN)或者残差神经网络(ResNet)来处理原子间的复杂相互作用。

-

模型优化:通过反向传播算法和梯度下降优化算法,调整神经网络的参数,以最小化预测势能与实际势能之间的误差。(此处需要AI训练算力)

-

高效的分子动力学模拟:

实时预测势能:训练完成的Deep Potential模型能够实时预测原子间的势能,避免了传统分子动力学模拟中耗时的力场计算。(此处需要AI推理算力)

精准的物理描述:由于神经网络模型可以学习复杂的非线性相互作用,Deep Potential能够提供更精确的分子动力学描述,特别是在描述高度灵活和动态的分子系统时效果显著。

-

应用和扩展性:

Deep Potential不仅适用于分子动力学模拟,还可以扩展到材料科学、化学反应动力学等领域。其高效的计算能力和准确性使其成为研究分子结构和性质、设计新材料以及理解化学反应机制的有力工具。

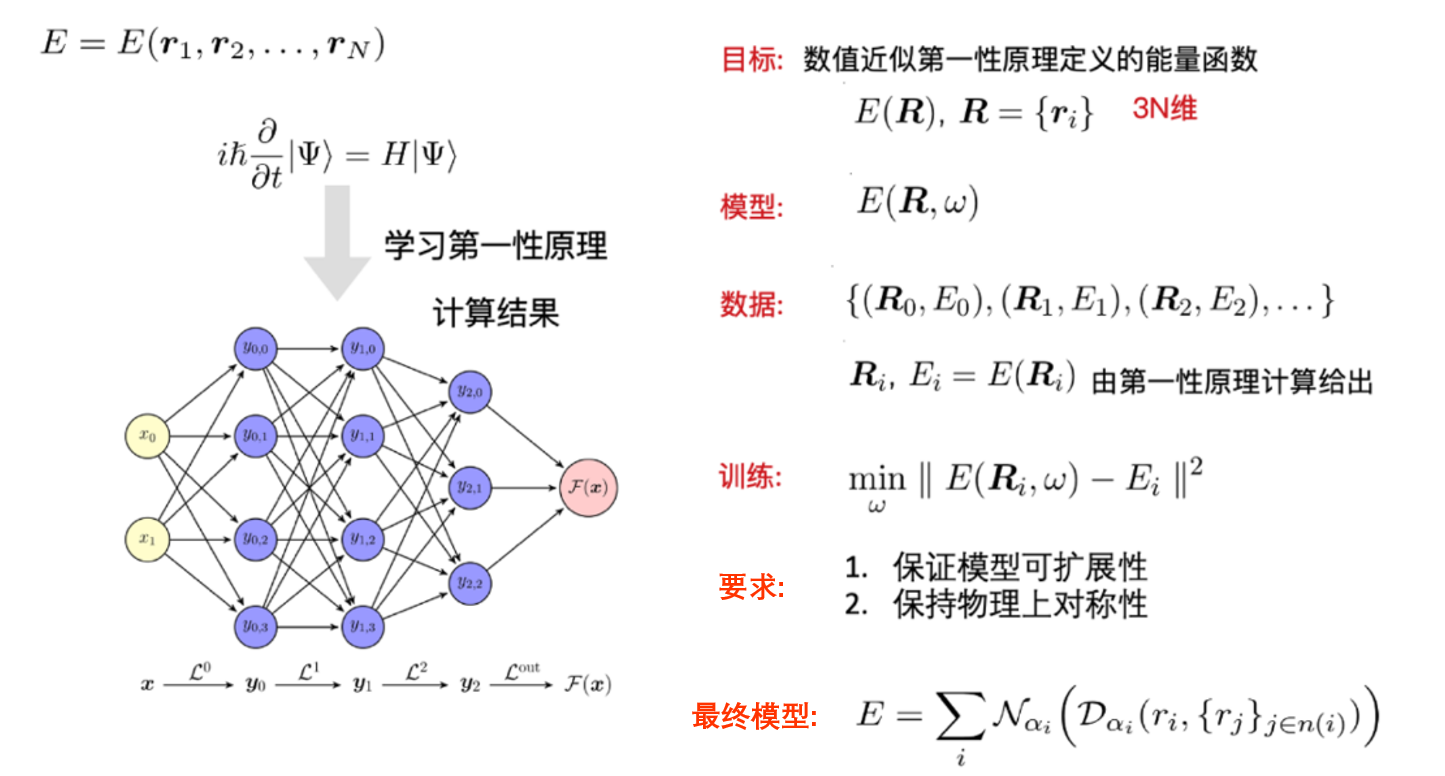

AI4S应用案例3: 碳纳米管的结构研究以及生长模拟

碳纳米管(CNT)是一种管状碳分子,直径仅为纳米级,堆叠时即使成千上万根也只有一根头发丝宽度。其特殊结构赋予了超强度、优异的热导率和磁阻等独特物理性质,适用于制造高性能复合材料、生物材料和半导体晶体管等领域。

复旦大学的研究团队利用AI for Science中的深度势能模型,成功预测了碳纳米管的晶体结构和原子能量,验证了模型在描述碳体系中的可靠性。此外,韩国基础科学研究所的研究团队在国际纳米管应用大会(NT22)上介绍了他们使用AI模拟和理解CNT生长过程的工作。他们开发了铁-碳机器学习力场(MLFF),能够以每天约70纳秒的速度模拟CNT的生长过程。

研究揭示了优化生长条件对提高CNT产率和质量的重要性,包括刻蚀速率与碳添加速率的优化比例。这些进展不仅为未来CNT的工业制造和应用奠定了理论基础,还展示了AI技术在加速材料科学研究中的潜力和应用前景。

AI for Science 仿真预测, 在无特殊工艺控制时,CNT 的"良率"仅为 37%

AI4S应用案例4: DeepMind助力核聚变物理仿真

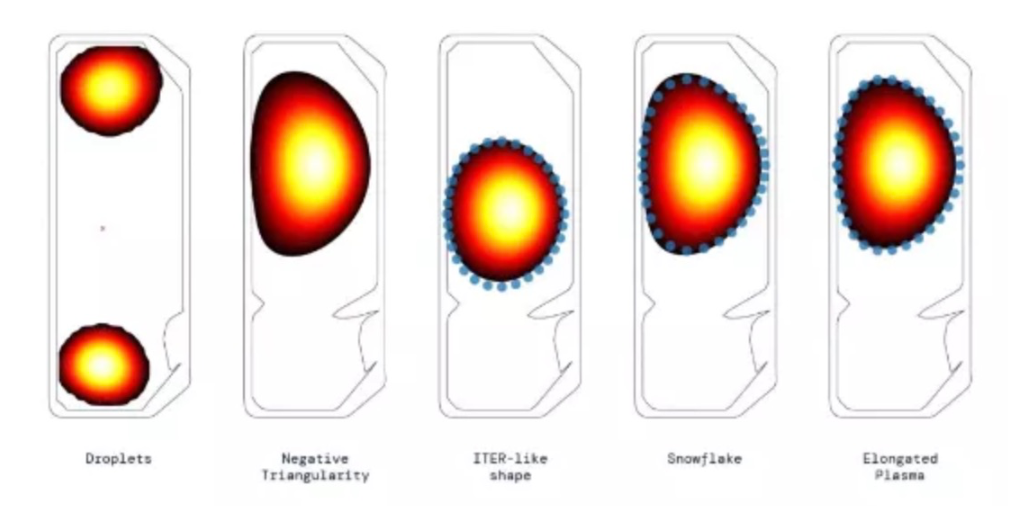

2022年,DeepMind与瑞士洛桑联邦理工学院等离子体物理中心合作,在《Nature》上发表了题为《Magnetic control of tokamak plasmas through deep reinforcement learning》的论文,开创了AI在核聚变控制中的新局面。核聚变是一种释放巨大能量的过程,被认为是人类能源理论的圣杯。长期以来,科学家和工程师们通过托卡马克装置试图实现可控核聚变,关键在于有效控制等离子体。

DeepMind团队从模拟器硬件开始,设置物理限制,要求AI模型严格遵循模拟器的准确结果,通过AI与Science的结合,提高了模型的精确度。他们开发了一个深度强化学习程序,能够有效控制复杂的等离子体配置操作。这一程序每秒进行一万次训练,通过大型神经网络预测等离子体形状和位置变化,并调整19块磁铁的电压以实现最佳操作。

2023年,DeepMind进一步优化了算法,将等离子体形状控制的精度提高了65%,减少了电流控制中的稳态偏差。这项研究使强化学习方法在实际托卡马克装置的控制中更加可行,同时提出了从模拟到实际的传递和训练加速方面的进一步研究方向。

DeepMind AI 控制下生成的几种不同等离子体几何形状